¿Qué es la Información? Parte I

by Marisa on Sep.15, 2011, under Información, La Física, Los Campos Energéticos

Tremenda pregunta…

La Real Academia Española define la información como la «Comunicación o adquisición de conocimientos que permiten ampliar o precisar los que se poseen sobre una materia determinada.» Pero es mucho, mucho más que eso. De acuerdo a Vlatko Vedral, Catedrático de la Universidad de Oxford «Las unidades de información son lo que crea la realidad, no la materia ni la energía.» Ante tal aseveración, no hay más remedio que entrar de pleno en el análisis de lo que es en «realidad» la información. Si bien el dicho dice «la información es poder» ahora se amplía la definición hasta absorber todo lo conocido e ignoto y desembocar en la información es VIDA -orgánica e inorgánica. En esta primera parte incluimos un reportaje de la revista de Redes para la Ciencia de Punset que aclara lo que es la información y en el siguiente debatiremos el contenido de una de las series de Redes más ovacionadas por el público que cubre el idilio entre la física cuántica, la información y la realidad.

«Vivimos en la era de la información, dicen. Cierto es que, ante los avances tecnológicos sin precedentes de las últimas décadas, quién no está informado, es porque no quiere. Nos encontramos hoy en pleno subidón comunicativo y el fenómeno suma y sigue, pero si nos ceñimos a la información como concepto científico, ésta no es algo exclusivo de nuestra era, ni tan sólo de la humanidad o de los seres vivos. La información existe en todos los rincones del universo con algún atisbo de organización desde el mismo momento del Big Bang pero sólo ahora nos hemos dado cuenta de ello y hemos aprendido a medirla.

La revolución de las tecnologías de la información y la comunicación (TIC) no se puede concebir sin la teoría de la información, publicada en 1949 por Claude Shannon, ingeniero y matemático de los Laboratorios Bell, en Nueva York, y Warren Weaver, también matemático y, por aquel entonces, director de la División de Ciencias Naturales de la Fundación Rockefeller, en la misma ciudad. La teoría surge de la necesidad de transmitir datos de un modo eficaz, rápido y seguro, en un momento en el que los avances de disciplinas como la cibernética, la informática o las telecomunicaciones iban a la par. Shannon y Weaver desarrollaron una metodología que permite medir la cantidad de información contenida en cualquier mensaje.

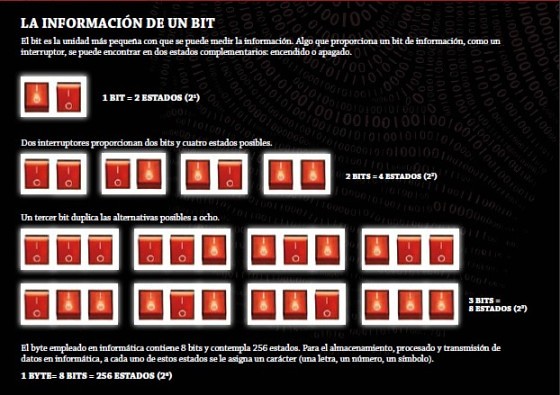

La información se convirtió en ese momento en magnitud física y, como tal, gozaría de una unidad fundamental para medirla, el bit, que ofrece dos alternativas contrapuestas: uno-cero, sí-no, verdadero-falso, presencia-ausencia, lleno-vacío, on-off (ver cuadro abajo).

Procesar información no es algo exclusivo de cerebros y ordenadores: vivimos en una gran computadora llamada universo

que almacena bits a todas las escalas

PERO ¿QUÉ ES LA INFORMACIÓN?

La idea de información se basa en analizar cuán probable es un mensaje de entre un cierto número de alternativas. Veamos un ejemplo de cómo se puede medir la información de esta forma. Imaginemos una partida del juego del ahorcado. El jugador menos aventajado es quien canta la primera letra. Esto es debido a que, al comienzo, el término que hay que desvelar se baraja entre un amplio abanico de posibilidades, que incluyen todas las palabras del diccionario con el mismo número de letras que la que se ha de adivinar. Pero tras cada carácter que se acierta, los jugadores van disponiendo de algo más de información a la que aferrarse; existe una mayor certeza de dar con ese término puesto que el número de opciones posibles va menguando. Así, la información ayuda a reducir la incertidumbre y a tomar decisiones; proporciona conocimientos del presente para actuar en el futuro.

Científicos de diferentes disciplinas, como las neurociencias, la lógica, la lingüística o la biología molecular, han trasladado la teoría a su área de estudio. Una de las claves del éxito del método reside en su simplicidad, puesto que el cálculo de la información se reduce a un problema de probabilidades no muy complicado. La información promedio de un mensaje se determina a partir de la probabilidad de que cada elemento que lo compone, sea elegido de entre un conjunto de alternativas. Siguiendo con el ejemplo del ahorcado, el mensaje sería la palabra que queremos desvelar, las letras, los elementos que componen dicho mensaje, y el conjunto de alternativas posible, el abecedario. Pero lo que ha favorecido el uso de este modelo en otros ámbitos ha sido, sobre todo, que permite estimar los bits de información de un mensaje con independencia de su significado, una libertad semántica con la que se ha dado rienda suelta al concepto de información para extrapolarlo a otros terrenos.

TODO LO QUE CONTIENE ORDEN, CONTIENE INFORMACIÓN

Cuantificar los bits que contiene cualquier cosa es factible. Tras su definición científica, la información ha sido interpretada como una medida de la complejidad de los sistemas físicos. Para el biólogo Tom Stonier, autor de La información y la estructura interna del universo (Hacer, 1996), esta magnitud “está intrínsicamente relacionada con la organización de un determinado sistema y se puede describir como la causa eficiente del estado de organización de éste”. Así, algo compuesto de elementos variopintos con relaciones enrevesadas entre ellos guarda más información que un conjunto de cosas monótonas y simples.

Por ejemplo, en la década de los 60, el ecólogo Ramon Margalef usó el índice de Shannon-Weaver para estudiar la biodiversidad de los ecosistemas. Aquellos más diversos, con numerosas especies representadas equitativamente, son los que registran mayor información. Para el ecólogo “la información se expresa por un mecanismo y almacenar información, significa incrementar la complejidad de este”. Dicho de otro modo, los seres vivos y sus relaciones han ganado y almacenado información a medida que se han ido volviendo más y más complejos a lo largo de los millones de años de evolución.

EL LARGO CAMINO HACIA LO SOFISTICADO

El desarrollo de la computación tras la teoría de la información ha posibilitado a los ordenadores almacenar y procesar más y más bits en menos y menos espacio. Seth Lloyd, investigador del Massachussets Institute of Technology (MIT) señala que “cada año y medio, el tamaño de los componentes informáticos se reduce a la mitad”. El científico asegura que como resultado de

este fenómeno, los ordenadores actuales pueden procesar cientos de miles de millones de bits por segundo, cantidad equiparable a la de nuestro cerebro.

Sin embargo, a pesar del ritmo frenético con que avanzan la informática, la computación o las telecomunicaciones, los ingenieros todavía no han logrado hacer que las máquinas gestionen los bits de un modo tan eficiente como lo hace la materia gris. Lloyd señala que “un ordenador se vuelve más rápido en cuanto a capacidad de procesamiento, pero eso no se traduce necesariamente

en una mayor sofisticación”. Un animal sencillo como puede ser una babosa marina, equipada con un cerebro de unos pocos miles de neuronas, es capaz de desempeñar todas las funciones complejas propias de su biología: se nutre, se reproduce, se desplaza, se defiende… Ésta es la sofisticación a la que se refiere el experto del MIT. En este sentido, apuesta que todavía faltan miles —¡o millones!— de años para que los ordenadores procesen información de un modo tan sofisticado como lo hacen las neuronas. En cambio, el cerebro animal es el fruto de un proceso evolutivo que ha durado un par de eones, durante los cuales, el sistema nervioso se ha ido depurando, mientras que el cerebro de nuestras máquinas apenas cumple 60 años de mejoras.

La información ayuda a reducir la incertidumbre y a tomar decisiones

LA VIDA ES INFORMACIÓN

Y no sólo el sistema nervioso procesa información en la naturaleza; todas las células cuentan también con sus microprocesadores. El ADN almacena información que la maquinaria celular se encarga de procesar e interpretar para fabricar proteínas, los componentes funcionales y estructurales de la célula. La vida se fundamenta en el ADN y, por lo tanto, en el procesado de los bits almacenados en dicha molécula.

Por tanto, la evolución de los seres vivos encuentra su raíz en el hecho de que la información va cambiando, mutando, con el paso de las generaciones. Asimismo, las células comparten datos con el resto del organismo al cual pertenecen, los procesan y actúan según el tipo de estímulo que reciban del otro lado de su membrana. El ADN, como cualquier otra molécula, se compone de átomos que guardan una relación y un orden. Es por este motivo por el que contienen información. Pero es que incluso la historia se repite en los niveles de organización inferiores, puesto que los átomos están formados por piezas aun menores agrupadas también de acuerdo con un orden. En el mundo no vivo, moléculas, átomos y partículas subatómicas también almacenan y procesan información.

En realidad, hace unos 13.700 millones de años, tras aquella gran explosión, el primer rudimento de universo empezó ya a procesar información. La enorme densidad de las partículas y la colosal temperatura a la que éstas estaban sometidas en el momento del Big Bang provocaron un número infinito de colisiones, cada una de las cuales registraba bits de información en constante crecimiento, al mismo ritmo que la materia se fue creando y el orden se fue imponiendo. El universo donde vivimos no es más que una gran computadora que registra y procesa información.

“Billones de billones de billones de billones de billones de billones de billones de billones de bits de información”, apunta Lloyd.

PARA SABER MÁS:

La información y la estructura interna del universo. Tom Stonier (Hacer, 1996). Descodificando el universo: cómo la nueva ciencia de la información nos explica todo el cosmos, desde nuestro cerebro hasta los agujeros negros. Charles Seife (Ellago Ediciones, 2009).

FUENTE:

Redes para la ciencia no. 8, UN UNIVERSO DE UNOS Y CEROS